Multimodal Transfer: A Hierarchical Deep Convolutional Neural Network for Fast Artistic Style Transfer

Published:

以下将分为3个部分介绍:

- 效果

- 解決的問題

- How to solve it?

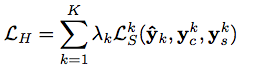

1.效果:

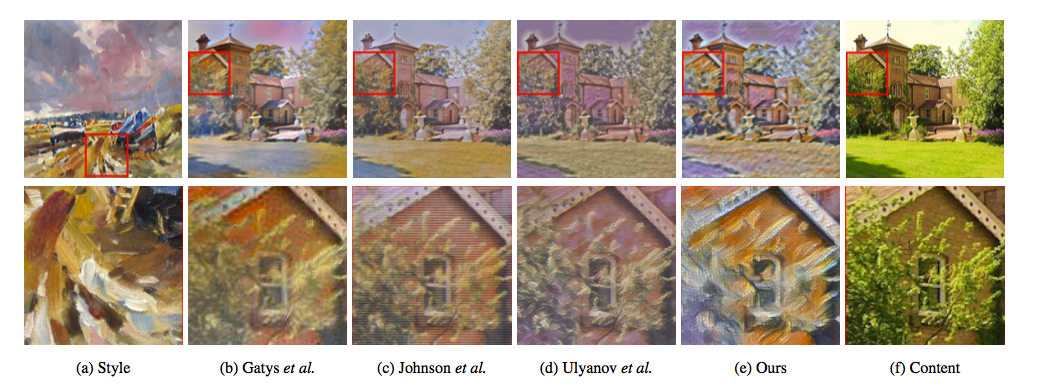

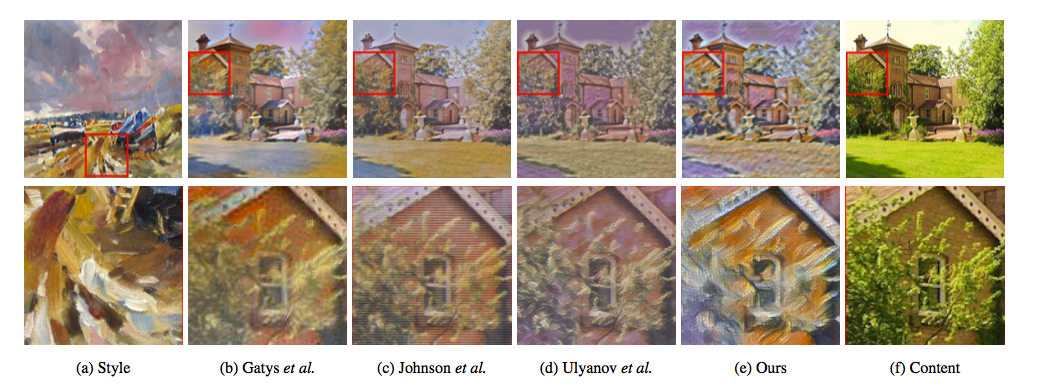

先来看一下效果

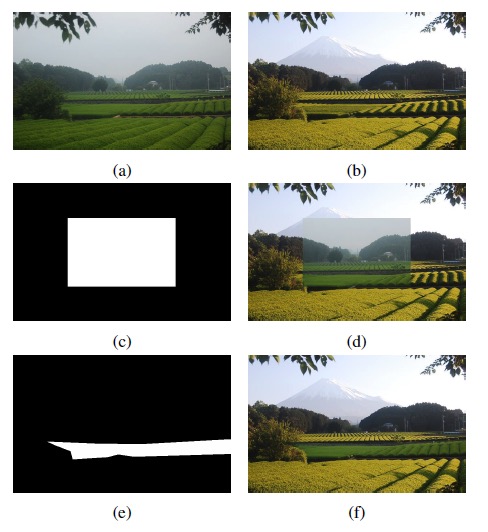

2.解决的问题: 通用框架下进行style transfer时候的笔触差异 原始的方法永远会和style差距较大

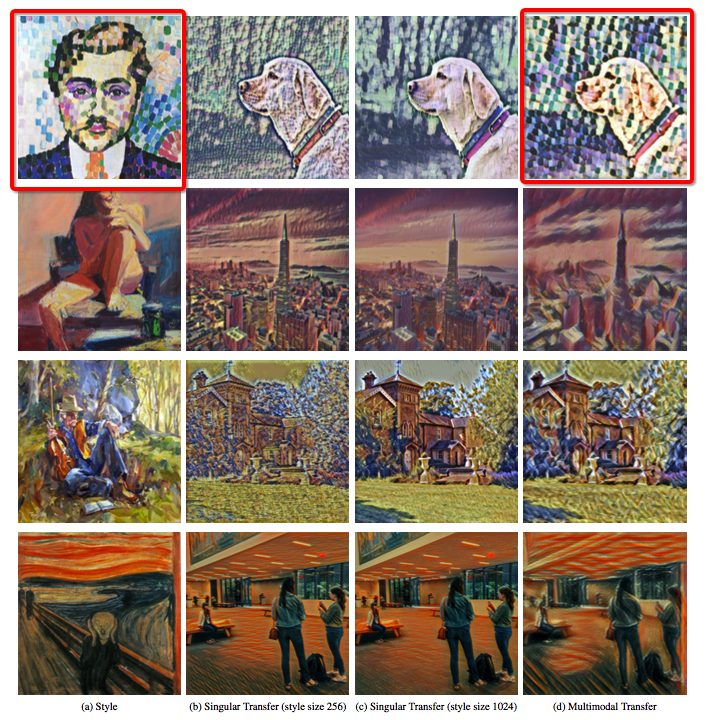

和我们之前方案类似 解决不同size下的笔触问题,如下图如果只用256的size去训练较coarse的笔触 或者 用1024的size去训练较fine的笔触 因此单独训练 学出来的结果的笔触会和原图有较大的出入。

3.How?

Easy way to improve it.

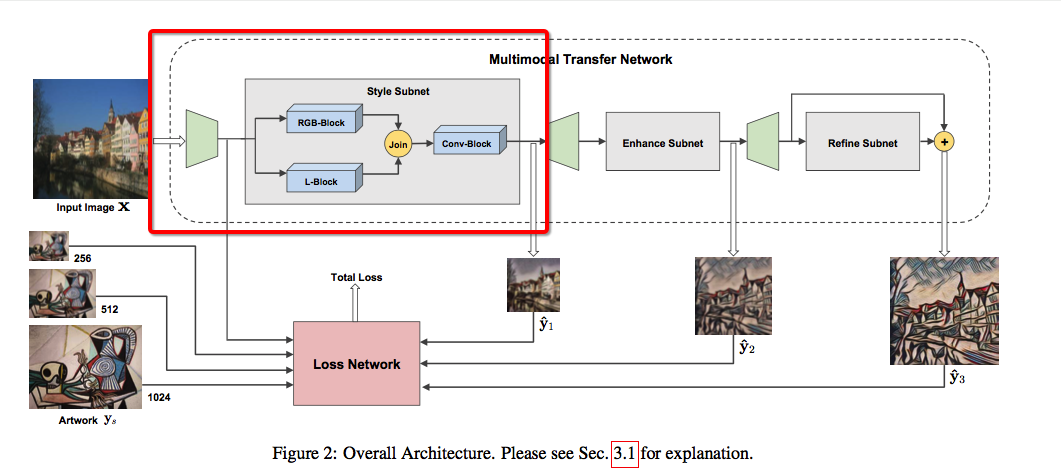

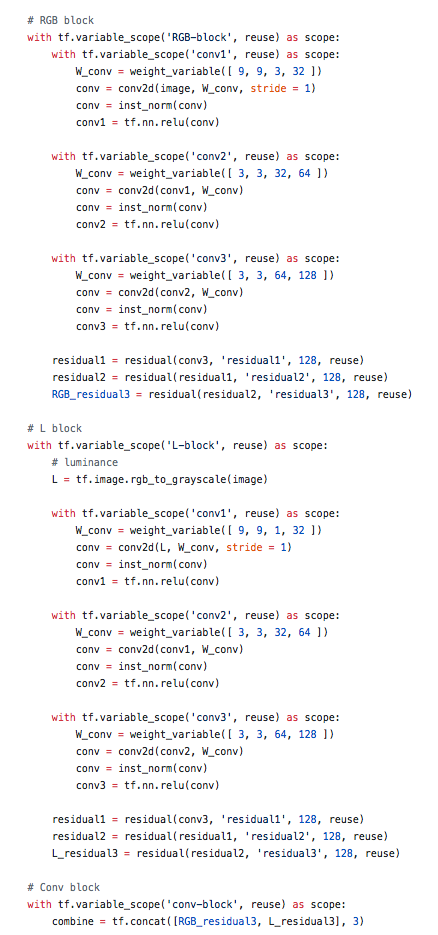

- Trick one 输入图片增加为 RGB + L 然后联合起来训练训练多一个通道的结构,原因是作者认为因为人类对L通道比较敏感 因此L通道可以辅助作为一个较好的信息输入指导。

Tensorflow Block 实现 Detail:

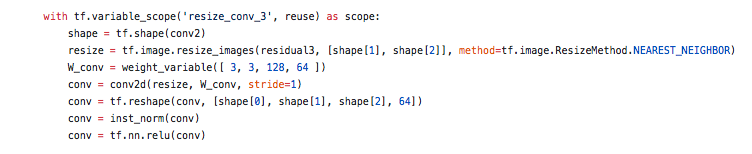

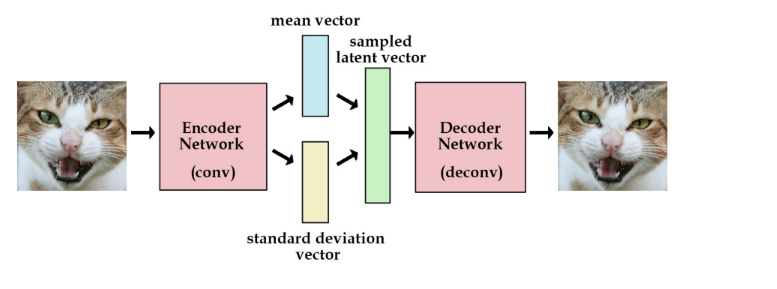

2.Trick2 把de-convolution 都换为bilinear upsampling的方式来避免checkerboard

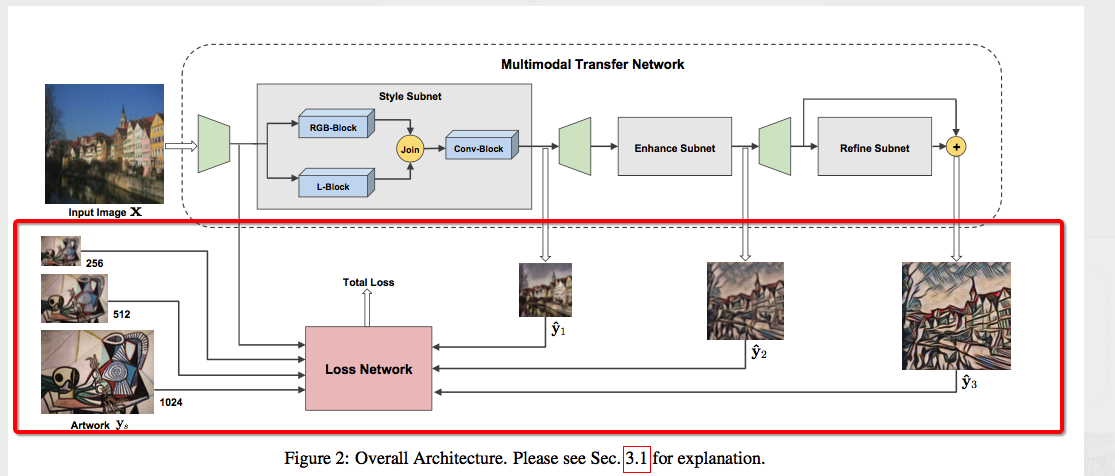

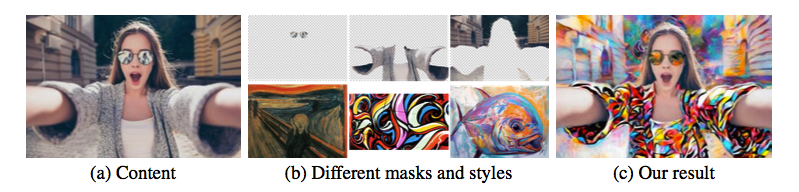

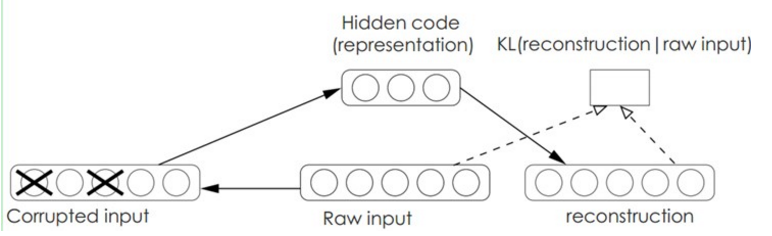

3.Trick3 模型迭代refine法 把模型分为三部分来进行训练refine。

分别为

1) Style Subnet(256) 用来捕获 color & texture traits

2) Enhance Subnet(512) 用来做stylization strength

3) Refine Subnet(1024) 用来remove local pixelization artifacts

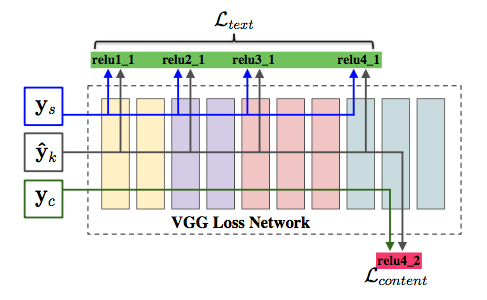

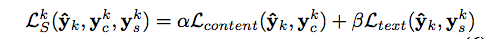

Loss组合为:

Scale Basic Loss = Content Loss + Style Loss

Combine Loss = a * Scale1 Basic Loss + b * Scale2 Basic Loss + c * Scale3 Basic Loss (a : b : c = 1 : 0.5 : 0.25)

Leave a Comment